Aldec 4K UltraHD イメージングソリューション

powered by TySOM-3-ZU7EV board (Zynq UltraScale+ MPSoC)

画像データ製作(CMOSイメージセンサ、ライブオンラインビデオストリームなど)とディスプレイパネルの両方で使用される増え続ける画像データ解像度のう要求を考慮すると、事実上4K UltraHDイメージング(2160p)が現在の標準になります。アプリケーションには、現在は家電、医療、自動車、プロフェッショナルA/V放送が含まれますが、これらに限定されずさらに拡大しています。専用のデスクトップソリューションでは、クラウドデータサービスへのアクセスでUltraHD画像計算を克服するのに十分な処理能力を備えていますが、それは特に低消費電力を考慮する必要がある場合で、組み込みのエッジ処理を行う際には依然として困難な場合があります。

アルデックは、Zynq UltraScale+ MPSoCベースのTySOM-3-ZU7EVプロトタイプボードでこの課題に対処します。これには、最大60fpsデータレートの高解像度4K画像データを取得、処理、表示するために必要なすべての接続性と処理能力が含まれています。

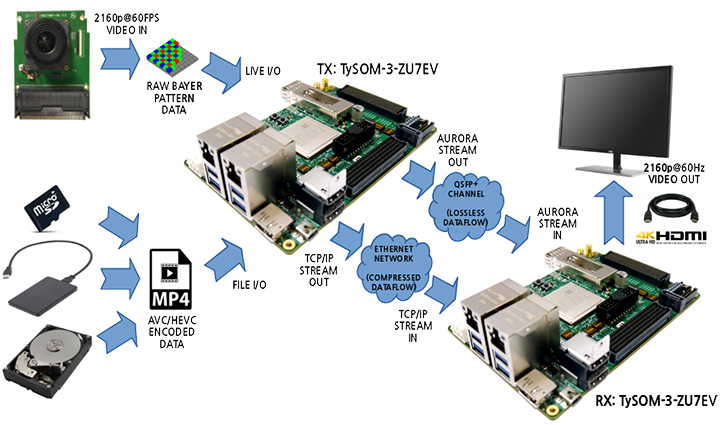

アルデックのクライアントは、ネットワークチャネル帯域幅と画像データ品質のどちらかを選択する必要はありません。4K処理バンドルはすでにこれらの両方の要件を満たし、2つの異なるタイプの画像ブロードキャストに焦点を当てた2つのLinuxベースソリューションを提供するためです:

• ソリューション #1: ロスレス生画像データ(QSFP+転送)

• ソリューション #2: 低ビットレートでエンコードされた画像データ(TCP/IP over Ethernet転送、ビデオコーデックユニット-VCUエンコード/デコード)

Figure 1: Aldec's 4K Imaging Solution Overview

これらの各ソリューションには、画像データが画像ソース(4K対応カメラなど)から同じTySOMボードに接続されたディスプレイ(HDMIまたはDP)まで単純に実行される特別なシングルボードバージョンも含まれています。

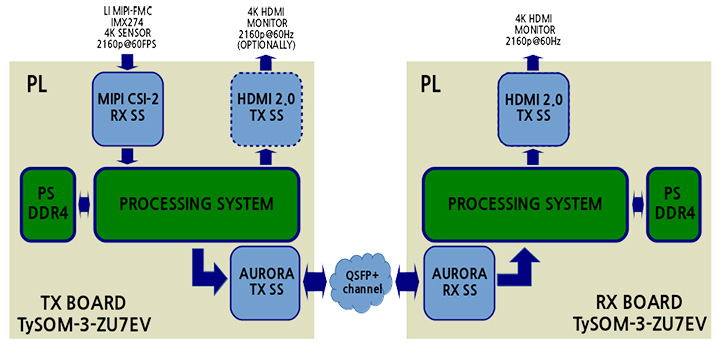

ロスレスRaw画像データ放送

このプロジェクトの主な目標は、オンボードのQSFP+周辺機器接続と高速ポイントツーポイントXilinx Aurora通信プロトコルを活用したオンチップシリアルトランシーバーを備えた高速QSFP+接続を使用して、ソースデバイスとデスティネーションデバイス間で未処理の高帯域幅画像データを送信する機能を実証することです。内部ピクセルデータ表現によると、2160p@60Hzのデータレートの帯域幅は約1GB/sであり、これは広く使用されている1Gbitイーサネットでは実現不可能な要求です。

デザインで使用される主なハードウェアコンポーネントと機能:

- Leopard Imaging LI-IMX274MIPI-FMC(v1.1)は、ビデオソースデバイスとしてSony IMX274 Imagerを使用

- ビデオ表示デバイスとしてHDMI/DPインターフェイスを搭載した4K対応モニタ

- Zynq UltraScale+ビルトインハードウェアブロック:DP 1.2aコントローラ(最大2160p@30Hz)、* Mali GPU

- Zynq UltraScale+ PLサイドソフトIPブロック:MIPI CSI2 RX SS、HDMI 2.0 TX SS(最大2160p @ 60Hz), Aurora TX / RX SS

- QSFP+準拠のメタルまたは光ケーブル

* Mali GPUはシングルボードGUIバージョンでのみ使用されます。

Figure 2: Lossless Image Dataflow

- シングルボード4Kパススルー(Zynq MPSoC Base TRD)

シングルボードデザイン用のLinuxデモアプリケーションは、GUIなしのコマンドラインアプリケーション、またはSony IMX274イメージセンサに対する追加のユーザー制御を搭載したより高度なQtベースのGUIアプリケーションの形式で提供されます。どちらのアプリケーションも、HDMI(最大2160p@60)またはDP(最大2160p@30)モニターでの画像表示をサポートしています。 Qtベースのデモアプリケーションは、内部のグラフィックハードウェアアクセラレーションに組込みのMali GPUを使用しています。

- デュアルボード4K QSFP+パススルー

ボード間通信は、低レベルGTベースのAurora通信プロトコルを使用して行われます。これにより低遅延および高データ帯域幅の要件を満たす大量の画像データを送信できます。さらに、高帯域幅のデータ転送に通常使用される高価な独自のマルチギガビットイーサネットの実装を置換えることにより、システム全体のコストを削減することもできます。同様に、シングルボードバージョンでは、データフローはLinuxユーザースペースアプリケーションの制御下にあり、両側を個別に構成する必要があります。

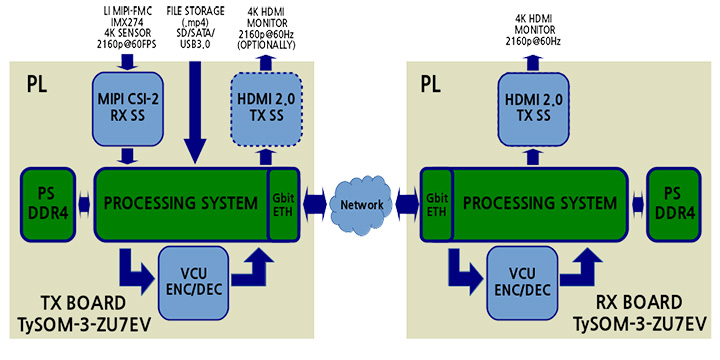

低ビットレートでエンコードされた画像データ放送

RAW画像ブロードキャストとは異なり、エンコードされた画像データは業界標準のギガビットイーサネット・ネットワークを介した転送に適しています。オンチップのビルトインVCUは、メモリ間のタスクをビデオエンコードおよびデコードし、低ビットレートで許容可能な画質を提供します。VCUは、H.264/AVC(高度なビデオコーディングとH.265/HEVC)最大2160p@60データレートの高効率ビデオコーディングなど、最も一般的なビデオ圧縮規格の両方をサポートしています。画像データフロー全体では、ピクセルデータがNV12形式(YUV 4:2:0の2プレーンバージョン)で表されていると想定しています。

デザインで使用される主なハードウェアコンポーネントと機能:

- Leopard Imaging LI-IMX274MIPI-FMC(v1.1)は、ビデオソースデバイスとしてSony IMX274 Imagerを使用

- ビデオ表示デバイスとしてHDMI/DPインターフェイスを搭載した4K対応モニタ

- Zynq UltraScale +ビルトインハードウェアブロック:DP 1.2aコントローラ(最大2160p@30Hz)、VCU、** Mali GPU、PS 1Gbitイーサネットコントローラ

- Zynq UltraScale + PLサイドソフトIPブロック:MIPI CSI2-RX SS、HDMI 2.0 TX SS(最大 2160p@60Hz)

- ファイルI/O用の不揮発性メモリストレージとしてのUSB3.0またはSATA HDD

** Mali GPUは、DPディスプレイのみのシングルボードGUIバージョンで使用されます。

VCUエンコーダおよびデコーダハードウェアの構成に使用される6つの事前定義済みプリセット(AVC(Low, Medium, High)およびHEVC(Low, Medium, High))があり、ターゲットビットレートはAVCおよびHEVC規格の両方でLow/Medium/Highに応じて10/30/60 Mbit/sです。圧縮設定の残りの部分(プロファイル、レート制御、GoPなど)は、使用されるすべてのプリセットで同じです.

Figure 3: Compressed Image Dataflow

- シングルボード4Kパススルー(Zynq MPSoC VCU TRD)

シングルボードVCUデザイン用のLinuxデモアプリケーションは、GUIなしのコマンドラインアプリケーション、またはVCUに対する追加のユーザー制御を搭載したより高度なQtベースのGUIアプリケーションの形式で提供されます。どちらのアプリケーションも、DP(最大2160p@30)モニタでの画像表示をサポートしています。HDMI(最大2160p@60)はGUIなしのアプリケーションのみサポートしています。どちらの場合でも、ユーザーアプリケーションは、OpenMAX Integration LayerとVCU CtrlSWミドルウェアを搭載した基盤となるGstreamerフレームワークを使用して動作します。

以下のVCUデータフローモードがサポートされています:

- 記録:VCUエンコーダを使用して、ライブ画像データをディスクストレージ上の.mp4ファイルに保存します(カメラのみ)

- 表示:VCUエンコーダ/デコーダはカメラからディスプレイに画像データを渡すため繰り返し使用されます。 ファイルI/Oの場合は、VCUのデコーダ部分のみが使用されます

- ストリーム:カメラ画像データはVCUデコーダを通過し、次にTCP/IPプロトコルを使用してネットワークを介して特定のIP/ポートに送信されます。ファイルI/Oの場合、.mp4ファイルデータは既にイーサネット転送用にエンコードされているためVCUをバイパスします。

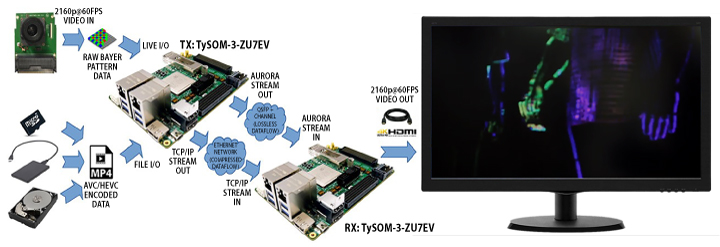

4K UltraHDイメージングでオプティカルフローを使用したモーション検出

モーション検出は、ADASおよびビデオ処理アプリケーションでのオブジェクト検出にとって重要な要素です。ビデオ内の動いているオブジェクトを見つけるには多くの方法があります。最も信頼できるものの1つはオプティカルフローです。TySOMユーザーの開発プロセスを容易にするために、アルデックはライブ4Kビデオのモーションオブジェクトを強調するオプティカルフローを4Kイメージングリファレンスデザインに追加しました。このデモのハードウェアセットアップは、上記で説明した4Kイメージングデモと同じです。

Figure 4: Aldec's Detection Using Optical Flow in 4K UltraHD Imaging

Corporate Headquarters

2260 Corporate Circle

Henderson, NV 89074 USA

Tel: +1 702 990 4400

Fax: +1 702 990 4414

https://www.aldec.com

©2026 Aldec, Inc.